728x90

반응형

아주 기본적인 내용이지만 글로 정리해보려고 한다.

스파크 처음하는 사람들에게 조금이라도 도움이 될까 해서!

스파크는 Spark Application과 Cluster manager로 구성되어 있다.

그리고 Spark Application에는 Driver와 Executor라는 두가지 JVM 프로세스가 포함되어 있다.

- Driver: Driver는 SparkSession/SparkContext를 생성하고, Job 을 제출하고 task로 변환하고, worker 간의 task 실행을 조정하는 주요 프로세스이다.

- Executor: Executor는 주로 특정 계산 작업을 수행하고 결과를 driver에게 반환하는 일을 담당한다.

Spark Application은 실제 일을 수행하며, Cluster manager는 Spark Application 사이에 자원을 중계해주는 역할을 담당한다.

Spark Application

Spark Driver 와 Executor에 대해 더 자세히 살펴보자.

- Spark Driver: 한 개의 노드에서 실행되며, 스파크 전체의 main() 함수를 실행한다. 어플리케이션 내 정보를 유지/관리한다. 사용자가 제출한 job을 task 단위로 변환하여 executor에게 전달한다.

- Executor: 다수의 worker 노드에서 실행되는 프로세스로 spark driver가 할당한 작업(task)를 수행하여 결과를 반환한다. 또한 블록매니저를 통해 cache 하는 RDD를 저장ㅎ나다.

Cluster Manager(클러스터 매니저)

Cluster Manager 는 스파크와 붙이거나 뗄 수 있는 컴포넌트로, Spark Application의 리소스를 효율적으로 분배하는 역할을 담당한다.

Spark는 executor에 task를 할당하고 관리하기 위하여 Cluster manager에 의존한다.

Spark는 단지 cluster manager와 통신하며 할당 가능한 Executor를 전달받으며 clustor manager의 상세 동작을 알지는 못한다.

스파크3.0 기준으로 Cluster manager의 종류는

- Spark StandAlone

- Hadoop Yarn

- apache mesos

- kubernetes 등이 있다.

Spark Application 실행 과정(흐름)

Spark를 사용할 때의 대력적인 실행 흐름이다.

- 사용자가 spark-submit을 통해 애플리케이션을 제출한다.

- Spark driver가 main()을 싱행하여 SparkContext를 생성한다.

- SparkContext가 Cluster Manager와 연결된다.

- Spark Driver가 Cluster Manager로부터 Executor 실행을 위한 리소스를 요청한다.

- Spark Context는 작업 내용을 Task 단위로 분할하여 Executor에게 전달한다.

- executor들은 작업을 수행하고 결과를 저장하여 driver에게 제출한다.

- Driver 의 main()이 끝나거나 SparkContext.stop()이 호출된다면 Executor들은 중지되고 Cluster manager에 사용했던 자원을 반환한다.

기타 개념 정리

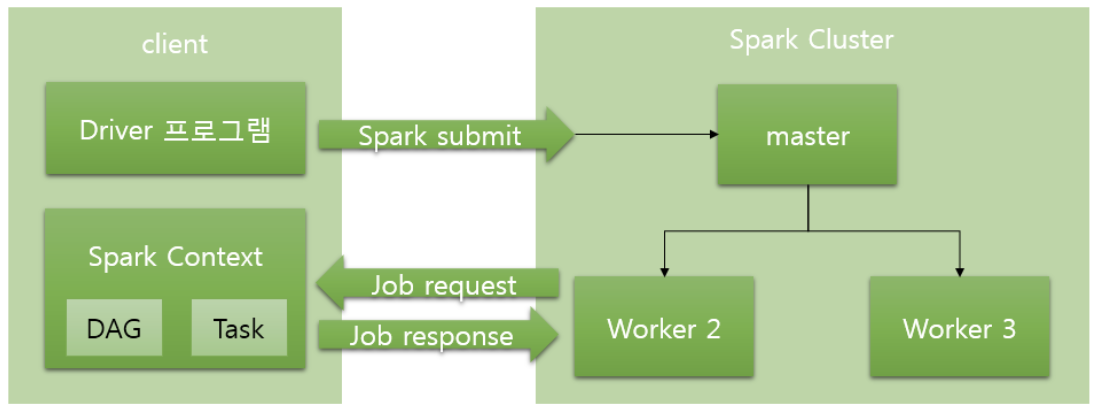

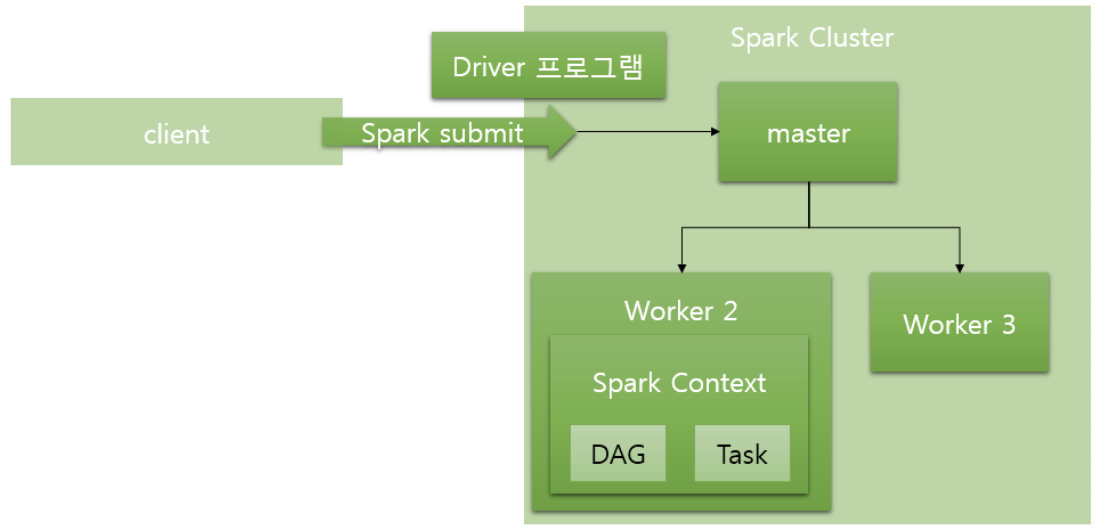

Deploy mode

cluster 사용시 driver 의 실행 위치를 지정한다.

- Client mode: Driver가 Cluster 외부에 위차치할 때

- Cluster mode: Driver가 Cluster 내부에 위치할 때

Job, Stage, Task

- Job: stage의 집합. Application 에서 spark에 요청하는 일련의 작업

- Stage: task의 집합

- Task: 하나의 Executor에서 수행되는 최소 작업 단위

728x90

반응형

'코딩해 > Kafka, Spark, Data Engineering' 카테고리의 다른 글

| Spark 로 Iceberg 테이블 comment(description) 추가 (0) | 2024.08.08 |

|---|---|

| [Spark] Executor 개수, 사이즈 정하기 | Spark 튜닝 성능개선 (2) | 2023.12.03 |

| [Spark] java.lang.AssertionError: assertion failed: Concurrent update to the commit log. Multiple streaming jobs detected for 해결방법 (0) | 2023.11.20 |

| [DB 엔지니어링] 유데미 강좌 - ACID (0) | 2023.07.24 |

| [데이터 중심 애플리케이션 설계] 1장 - 신뢰할 수 있고 확장 가능하며 유지보수하기 쉬운 애플리케이션 (0) | 2023.03.22 |