Gitmoji

Gitmoji란 git + emoji를 합친 말로 gitmoji를 이용하여 commit message를 작성할 때 어떤 종류의 변경/커밋인지 아이콘으로 표시할 수 있는 기능이다.

gitmoji를 사용하면 가독성이 올라가기도 하며 커밋 자체가 예뻐진다!

IntelliJ / PyCharm 에서 설치법

보통 코드 commit 을 IntelliJ나 PyCharm 에서 하므로 여기에 적용해 두면 편하다.

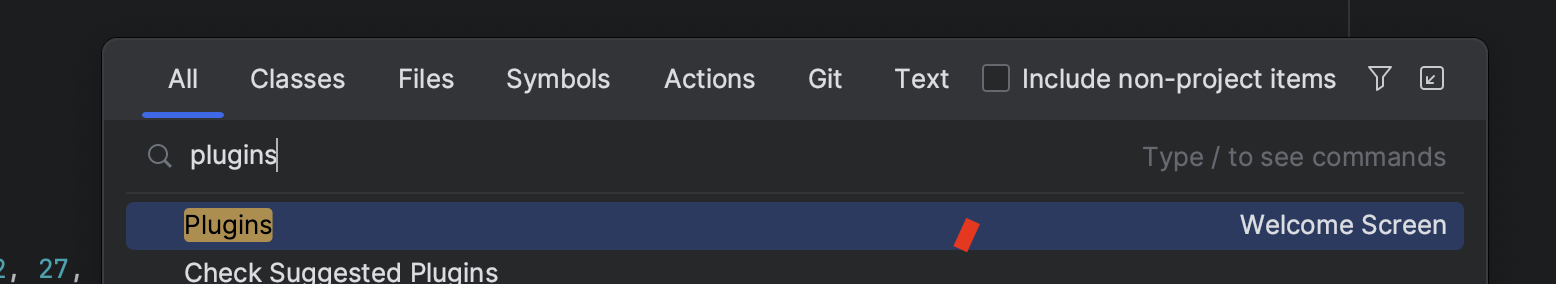

1. shift 키 두번 눌러서 'plugins' 검색

2. Marketplace에 gitmoji 검색

3. 설치하고 재시작 해주면 끝이다!

아래는 gitmoji 아이콘별 코드, 설명이다.

| 아이콘 | 코드 | 설명 | 원문 |

| 🎨 | :art: | 코드의 구조/형태 개선 | Improve structure / format of the code. |

| ⚡️ | :zap: | 성능 개선 | Improve performance. |

| 🔥 | :fire: | 코드/파일 삭제 | Remove code or files. |

| 🐛 | :bug: | 버그 수정 | Fix a bug. |

| 🚑 | :ambulance: | 긴급 수정 | Critical hotfix. |

| ✨ | :sparkles: | 새 기능 | Introduce new features. |

| 📝 | :memo: | 문서 추가/수정 | Add or update documentation. |

| 💄 | :lipstick: | UI/스타일 파일 추가/수정 | Add or update the UI and style files. |

| 🎉 | :tada: | 프로젝트 시작 | Begin a project. |

| ✅ | :white_check_mark: | 테스트 추가/수정 | Add or update tests. |

| 🔒 | :lock: | 보안 이슈 수정 | Fix security issues. |

| 🔖 | :bookmark: | 릴리즈/버전 태그 | Release / Version tags. |

| 💚 | :green_heart: | CI 빌드 수정 | Fix CI Build. |

| 📌 | :pushpin: | 특정 버전 의존성 고정 | Pin dependencies to specific versions. |

| 👷 | :construction_worker: | CI 빌드 시스템 추가/수정 | Add or update CI build system. |

| 📈 | :chart_with_upwards_trend: | 분석, 추적 코드 추가/수정 | Add or update analytics or track code. |

| ♻️ | :recycle: | 코드 리팩토링 | Refactor code. |

| ➕ | :heavy_plus_sign: | 의존성 추가 | Add a dependency. |

| ➖ | :heavy_minus_sign: | 의존성 제거 | Remove a dependency. |

| 🔧 | :wrench: | 구성 파일 추가/삭제 | Add or update configuration files. |

| 🔨 | :hammer: | 개발 스크립트 추가/수정 | Add or update development scripts. |

| 🌐 | :globe_with_meridians: | 국제화/현지화 | Internationalization and localization. |

| 💩 | :poop: | 똥싼 코드 | Write bad code that needs to be improved. |

| ⏪ | :rewind: | 변경 내용 되돌리기 | Revert changes. |

| 🔀 | :twisted_rightwards_arrows: | 브랜치 합병 | Merge branches. |

| 📦 | :package: | 컴파일된 파일 추가/수정 | Add or update compiled files or packages. |

| 👽 | :alien: | 외부 API 변화로 인한 수정 | Update code due to external API changes. |

| 🚚 | :truck: | 리소스 이동, 이름 변경 | Move or rename resources (e.g.: files paths routes). |

| 📄 | :page_facing_up: | 라이센스 추가/수정 | Add or update license. |

| 💡 | :bulb: | 주석 추가/수정 | Add or update comments in source code. |

| 🍻 | :beers: | 술 취해서 쓴 코드 | Write code drunkenly. |

| 🗃 | :card_file_box: | 데이버베이스 관련 수정 | Perform database related changes. |

| 🔊 | :loud_sound: | 로그 추가/수정 | Add or update logs. |

| 🙈 | :see_no_evil: | .gitignore 추가/수정 | Add or update a .gitignore file. |

'코딩해 > 개발개발 이것저것' 카테고리의 다른 글

| 데이터 엔지니어 인터뷰 질문 (0) | 2023.06.07 |

|---|---|

| [MacOS] Java 설치 (0) | 2023.05.04 |

| [Linux] error: no tty present and no askpass program specified (0) | 2023.04.18 |

| [Linux] E437: terminal capability "cm" required (0) | 2022.08.10 |

| [HTTP] 상태코드 | Multi status response 207 | HTTP Response | Python API 개발 (0) | 2022.05.16 |